People Analtyics. Eine weitere dieser, eigentlich nicht-aufhaltbaren, stetig wachsenden, datengetriebenen Entwicklungen der berechnenden Zukunft. Diesmal für die Personalabteilungen und das Human Ressource Management.

Ursprünglich war ich durch diesen t3n Artikel auf das Thema aufmerksam geworden. Dort wird auf einen Vortrag bei der Konferenz der deutschen Internet-Boheme re:publica verwiesen. Die Personalabteilungen sollen, nach den Wünschen der Anbieter*innen von People Analytics Software, in Zukunft alle Bereiche des Mitarbeiter*innen-Managements (manchmal auch „talent management„) besser und effizienter gestalten können. Dabei hilft die in die Zukunft gerichtete Performanceberechnung genauso wie die Beförderungs- und Kündigungsvorhersage.

Einstellungen

Am ausgereiftesten ist dabei das (Vor-)Sortieren von Bewerber*innen. Bewerbungsverfahren zielen ja seit jeher darauf ab eben diejenigen Bewerber*innen auszufiltern, denen die beste Performance im Unternehmen vorausgesagt wird. Assessment-Center mit ihren stark standardisierten Auswahlverfahren und Methoden sind dazu ab einer bestimmten Unternehmensgröße keine Seltenheit mehr. Über solche Organisationseinheiten wird schon lange ((laut Wikipedia stammt die Idee aus den 1920ern und wurde spätestens in den 1970er Jahren populär)) versucht die Einstellungsprozesse zu objektivieren und die Persönlichkeiten der Bewerber*innen möglichst umfassend zu vermessen.

Die früher manuell ausgewerteten Fragebögen und Interviews werden in den letzten Jahren vermehrt automatisiert verarbeitet und die Ergebnisse durch weiteren Datenquellen erweitert. Als Kriterien soll dabei herangezogen werden, was wirklich wichtig ist, nicht mehr nur der subjektive Eindruck während des Bewerbungsgesprächs. In einem sehr ausführlichen Bericht in The Atlantic zieht Don Peck dann auch direkt einen Vergleich zu Moneyball. Anhand der Geschichte des Baseballclubs, die hier im Blog auch schon besprochen wurde, wird die Notwendigkeit und vor allem die (temporären) Erfolge der objektivierten Bewertung von Spieler*innen besprochen.

Peck sammelt eine ganze Reihen von Studien und Beispielgeschichten, um zu zeigen, dass klassische Auswahlverfahren doch – mindestens implizit – vorurteilsgeleitet waren. Dank Big Data können wir aber in Zukunft endlich objektiv werden, was doch im Sinne aller Beteiligten sein müsste. So wird zum Beispiel folgendes Studienergebnis zitiert:

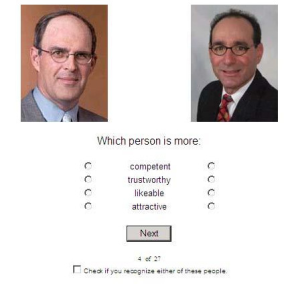

In 2010, three professors at Duke’s Fuqua School of Business asked roughly 2,000 people to look at a long series of photos. Some showed CEOs and some showed nonexecutives, and the participants didn’t know who was who. The participants were asked to rate the subjects according to how “competent” they looked. Among the study’s findings: CEOs look significantly more competent than non-CEOs; CEOs of large companies look significantly more competent than CEOs of small companies; and, all else being equal, the more competent a CEO looked, the fatter the paycheck he or she received in real life. And yet the authors found no relationship whatsoever between how competent a CEO looked and the financial performance of his or her company. – Aus They are Watching You at Work, Don Peck – The Atlanic, 2013

Ein wesentliches Merkmal von Geschäftsführer*innen in amerikanischen Unternehmen sei also, dass sie signifikant kompetenter aussähen als vergleichbare nicht-Geschäftsführer*innen, sich dies aber in den Finanzwerten der Firma nicht unbedingt nieder schlagen würde. ((John R. Graham, Campbell R. Harvey, Manju Puri, A Corporate Beauty Contest, 2010 zuletzt besucht am 17.6.2015.))

Beispiel Vergleichsbilder aus der Studie von Graham et. al 2010

Abgesehen von pauschalen Grundannahmen, das etwa die Qualität eines CEO sich direkt im finanziellen Erfolg eines Unternehmens niederschlage finde ich das Studiendesign mit dem Bildvergleich etwas merkwürdig. Der Hauptfehler liegt allerdings in der halb-korrekter Rezeption der Ergebnisse.

Das die CEOs signifikant kompetenter aussahen als nicht-CEOs wird auch in dem Artikel nur als statistisch signifikant dargestellt. Tatsächlich haben die Teilnehmer*innen, nur 53% der CEOs anhand des Fotos für kompetenter gehalten. Der Effekt „Kompetent aussehen macht einen eher zum CEO“ ist zwar vorhanden (signifikant) aber in der Praxis wirklich gering. Nichts desto trotz wird es das Ergebnis vermutlich in noch verkürzterer Form in unendlich viele „10 Dinge die eine*n guten CEO ausmachen“ Listen schaffen.

Weitere Beispiele für Jobbesetzungen auf Basis unfairer Kriterien beziehen sich häufig auf sexistische und rassistische Vorurteile, die man mit Datenanalysen umgehen könne. Allerdings lassen sich viele dieser vorurteilsbeladenen Bewerber*innenauswahlen auch ohne Big Data sondern mit einfachen organisatorische Maßnahmen wie anonymisierten Bewerbungen verhindern. Denn wer sagt denn, dass ein Algorithmus nicht die selben Vorurteile übernimmt wie sie auch Menschen sich antrainieren. Wenn in den USA die Quote von Nicht-Weißen in Gefängnissen deutlich über der von Weißen liegt, spricht doch im Prinzip alles dafür, dass ein selbstlernender Algorithmus nicht-weiße Bewerber*innen auf einen Job im Sicherheitsbereich vorab aussortiert – die Daten wollen es nicht anders.

Vivienne Ming, Gild’s chief scientist, told me that one solid predictor of strong coding is an affinity for a particular Japanese manga site. – Aus They are Watching You at Work, Don Peck – The Atlanic, 2013

Eine Gefahr liegt auch darin, dass Diskriminierungen in Zukunft auf Basis von Kategorien geschehen, die nicht so explizit juristisch geächtet sind. So werden führende Mitarbeiter der Firma Evolv ((andere sind Entelo oder Gild)) von Peck damit zitiert, dass sie bestimmte Daten zwar auf keinen Fall verwerten, aber sehr wohl andere, generelle Urteile fällen. Zum Beispiel: Wer ein Online-Bewerbungsformular mit einem Browser bearbeitet den er*sie der nicht vorinstalliert ist (also nicht Internet Explorer unter Windows oder Safari unter Mac), schneidet statistisch gesehen im Job besser ab. Eigentlich also nur konsequent, wenn man viele Bewerbungen hat, schon frühzeitig die auszusortieren, die nicht mal dazu in der Lage sind ihre eigenen Arbeitsgeräte zu konfigurieren. Das es 1000 Gründe dafür gibt, warum jemand ausgerechnet den vorinstallierten Browser für ein Bewerbungsformular benutzt (ob ein anderer installiert, aber nicht benutzt wird, kann nicht ausgewertet werden) ist dabei nicht von Interesse. So funktionieren Vorurteile.

Bloß nicht verklagbar sein

Ein wesentliches Interesse der Unternehmen in der behaupteten „Win-Win“-Situationen liegt zudem jenseits der Objektivierung der Auswahl. Es geht um den Schutz vor Diskriminierungsklagen. Dass es den Dienstleistern nicht um eine moralische Argumentation und Chancengleichheit geht, sondern vor allem um Compliance zeigt sich anhand der Tatsache, dass Evolv nach eigener Aussage auch Analysen mit Merkmalen durchgeführt hat, die in der EU und den USA nicht ausgewertet werden dürfen (wie Gender, Ethnie oder Religion). Nur eben außerhalb dieser Länder. Das Ziel ist nicht wirklich Diskriminierung zu verhindern, sondern nur die Chancen zu verringern, dass der*die Auftraggeber*in wegen Diskriminierung verklagt wird.

Automatisierte Einstellungen

Mittelfristig ist die Entwicklung aber scheinbar ähnlich wie bei den Kreditscores, die man von der SCHUFA kennt. Die Verantwortung für die Entscheidung trägt zwar noch jeweils ein Mensch, aber bei der Entscheidung selbst wird sich gerne auf die vermeintlich objektiveren Argumente der Maschine verlassen. So zumindest entwickelt es sich bei Xerox, die ein Online-Assessment-Center eingerichtet haben, dass pro Bewerber*in am Ende einen Score ausspuckt:

When Xerox started using the score in its hiring decisions, the quality of its hires immediately improved. […] Xerox still interviews all candidates in person before deciding to hire them, Morse told me, but, she added, “We’re getting to the point where some of our hiring managers don’t even want to interview anymore”—they just want to hire the people with the highest scores. – Aus They are Watching You at Work, Don Peck – The Atlanic, 2013

Besonders beliebt ist die automatisierte Bewertung von Bewerber*innen bei Unternehmen wie Call-Centern und großen Einzelhandelsketten, die sich als Arbeitgeber*innen dadurch auszeichnen, dass dort niemand besonders lange arbeitet. Bis zu 50% Turnover pro Jahr – also 50% der Mitarbeiter*innen verlassen das Unternehmen wofür Ersatz eingestellt wird – sei in diesen Branchen nichts unübliches. Faire, weil objektivierte, Bewerbungsverfahren an die sich dann ziemlich miese Arbeitsbedingungen anschließen, so zumindest interpretier ich die Statistik der Turnovers, ist also auch möglich mit People Analytics.

Aufsteigen und Aussteigen

Ein weitere Bereich beschäftigt sich mit Mitarbeiter*innen die mittelfristig für dasselbe Unternehmen arbeiten. Schon 2009 macht die Story die Runde, dass Google einen Algorithmus entwickelt habe mit dem ermittelt werden könne, wie wahrscheinlich es ist, dass ein*e Mitarbeiter*in bald das Unternehmen verlässt. Auch zur Untersuchung der Arbeitszufriedenheit ist es kein Novum mit Fragebögen und Mitarbeiterbefragungen zu messen. In wie fern Google hier neue Techniken anwendet ist nicht bekannt geworden, Nachfolgeberichte über den Erfolg oder eine Kommerzialisierung der Software hat es nicht gegeben. ((Eine ähnliche Anwendung ist Insight Applications von „Workday“ (siehe Bericht bei t3n), die allerdings bisher auch nur angekündigt und nicht verfügbar ist))

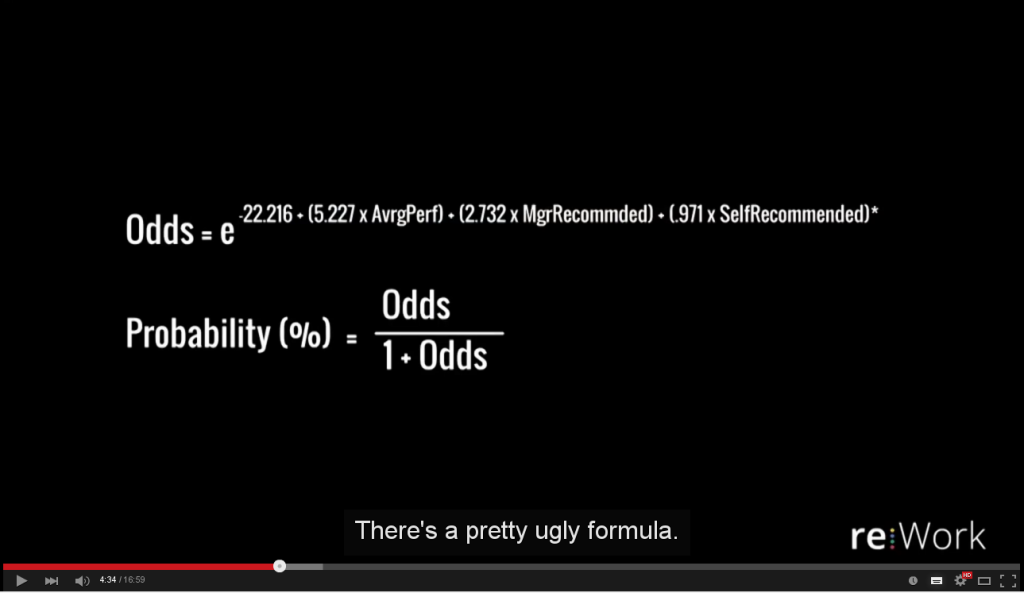

Still aus HR meets science at Google with Prasad Setty, 2014

Interessant im Bezug auf People Analytics bei Google ist ein Video aus dem vergangen Jahr. Ein HR-Manager berichtet, dass sie auf Basis der bekannten Daten für 30% der Personalentscheidungen bei der Beförderung ihrer Engeneers einen Algorithmus entwickeln konnten der in 90% der Fällen die Entscheidung korrekt vorhersagt (siehe Algorithmus im Screenshot). Die Anekdote die er dazu erzählt ist, dass der Vorschlag, man könne die Entscheidungen nun teil-automatisieren, nicht besonders gut ankam. Die Techniker_innen, denen damit mehr Zeit für Entscheidungsfindung über Beförderungen bei den übrigen 70% gegeben werden sollte, nahmen das Modell an, um herauszufinden, welche Kriterien im Modell nicht nicht genug gewichtet waren, vollständig automatisieren wollten sie ihre Arbeit aber nicht. Seitdem ist insgesamt die People Analytics Strategie nicht mehr auf Automatisierung ausgerichtet, sondern zielt darauf Entscheidungen zu informieren.

Trends

Sowohl Evolv als auch die Google wollen gerne noch mehr Daten sammeln und organisieren Langzeitanalysen (bei Google heißt die gDNA). Natürlich sei das Hauptziel nicht die Optimierung des Menscheneinsatzes sondern wieder die Win-Win Situation bei der auch den Leuten bei der eigenen Selbstoptimierung geholfen wird, auch wenn sie den*die Arbeitgeber*in wechseln.

Andere Ideen zu der „nächsten Generation“ von People Analytics hat John Sullivan. Inspiriert vom Baseball träutm er von einem WAR Score der pro Mitarbeiter*in errechnet, welche monetären Verlust es gäbe, müssten man die Person durch eine durchschnittle andere Ersetzen, oder der Vorhersage Produktivitätseinbußen durch Mitarbeiter*innen die „auffälliges Verhalten“ zeigen.

Auch wenn Datenschutzrechte bei Angestellten auch in Deutschland etwas aufgeweichter sind und Arbeitgeber*innen mit einem Linientreuen Personalrat sehr viel durchsetzen können, hoffe ich, dass sich die Ideen von Herrn Sullivan nicht durchsetzen.

Schreibe einen Kommentar