Auf Wired.com fand ich einen interessanter Beitrag zu einer Studie über eine, in den USA, genutzte Software zur Berechnung des Rückfallrisikos von Straftäter*innen. Doe Software wird von Gerichten eingesetzt und Richter*innen nutzen Sie als Informationsquelle, wenn sie Entscheiden ob jemand auf Kaution frei kommen kann, oder eine Strafe zur Bewährung ausgesetzt wird. Die Studie zeigt, dass Laien in etwa genauso gute Einschätzungen liefern wie der Algorithmus.

Compas und der Racial Bias

Im vorvergangenen Jahr hatte ProPublica bereits gezeigt, dass die Software einen rassistischen Bias hat. Für Weiße werden wesentlich häufiger ein geringeres Risiko berechnet, als für Afro-Amerikaner*innen.

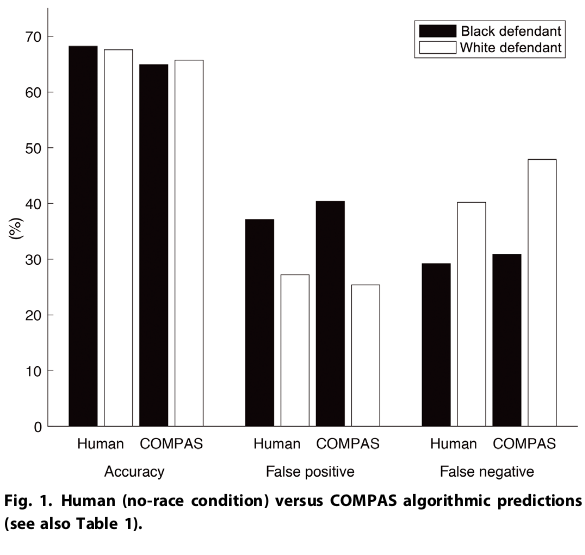

Vergleich der Genauigkeit und der falschen Einschätzungen abhängig von der Hautfarbe bei COMPAS und untrainierten Crowdworkern. Die Daten aus der neuen Studie bestätigen die Veröffentlichung von 2016.1

Der Bias ist dabei nicht explizit. Für die Berechnung der Rückfallwahrscheinlichkeit wird explizit darauf verzichtet die Hautfarbe oder das Geschlecht zu berücksichtigen. Dass die Vorhersage trotzdem trotzdem implizit rassistisch entscheiden liegt an der Struktur der amerikanischen Gesellschaft in der Afroamerikaner*innen wesentlich häufiger und härter bestraft werden als solche mit weißer Haut. Damit ändert sich die Datenlage für diese Gruppe und da Vorstrafen und -Länge vom Algorithmus berücksichtigt werden, werden sie zur Proxydaten. Die Daten scheinen farbenblind, aber der Effekt bleibt der gleiche. Für Deutschland kenne ich solche Statistiken nicht, aber es gibt Hinweise, das nicht-deutsche (nur die Nationalität, nicht die Hautfarbe wird hier erfasst), bei gleichen Taten häufiger angezeigt werden.

Neue Studie zur Qualität der Berechnungen

ProPublica hat auch 2016 schon die grundsätzliche Qualität der Daten in Frage gestellt. Die Genauigkeit der Berechnung unabhängig von den Straftaten liegt demnach bei 61% lag (andere Studien kommen nach dem Bericht auf um die 70%) und damit im vorgegebenen Toleranzbereich. Allerdings sinkt die Korrektheit der Vorhersage auf 20% für Fälle in denen eine hohe Wahrscheinlichkeit berechnet wurde, dass Täter*innen später für ein Gewaltverbrechen belangt werden.

Die aktuelle Studie ist dem nun noch weiter nachgegangen. Sie haben über Amazons Crowdsourcing-Tool Laien einschätzen lassen für wie wahrscheinlich sie es halten, dass eine Person wieder straffällig wird. Dazu wurden den Teilnehmer*innen Texte wie der folgende vorgesetzt, bevor sie eine Einschätzung geben sollten.

The defendant is a [SEX] aged [AGE]. They have been charged with: [CRIME CHARGE]. This crime is classified as a [CRIMI- NAL DEGREE]. They have been convicted of [NON-JUVENILE PRIOR COUNT] prior crimes. They have [JUVENILE- FELONY COUNT] juvenile felony charges and [JUVENILE-MISDEMEANOR COUNT] juvenile misdemeanor charges on their record. (Aus Dressel/Farid, 2018)

Das überraschende Ergebnis: Die ungeschulten Clickworker*innen waren genauso gut wie die Software. „Genauso gut“, meint dabei übrigens auch „genauso rassistisch“ (siehe Bild oben). Darüber hinaus haben die Forscher*innen sich auch an einem eigenen Algorithmus versucht, und konnte eine ähnliche Genauigkeit erreichen, wenn sie nur die Faktoren „Alter“ und „Anzahl der Vorstrafen“ betrachtet haben.

„Gut Genug“ ist nicht gut genug

Die Firma verteidigt sich und ihr Produkt in einer Pressemitteilung: Die Studie sei nicht ganz korrekt (die Anzahl der Faktoren die COMPAS zur Berechnung heranziehe seien sechs nicht 137), aber im wesentlichen sei die Genauigkeit so auch ok und im Rahmen üblicher Toleranzwerte. Während das statistische Argument vielleicht zieht, ignoriert der Hersteller vollständig die Effekte die ihre Software über die reine Berechnung hinaus hat.

In einem längere Beitrag auf Fivethirtyeight hat eine Gruppe von Autor*innen hervorgehoben, dass solche Software immer auch mit einem Ziel genutzt wird, sei es das Wiederholungstaten reduziert oder möglichst viele Personen auf Kaution freigelassen werden.

The core questions around risk assessment aren’t about data. They are about what the goals of criminal justice reforms should be. Some supporters see reducing incarceration as the primary goal; others want to focus on reducing recidivism; still others want to eliminate racial disparities. Risk assessments have drawn widespread support in part because, as long as they remain in the realm of the theoretical, they can accomplish all those goals. But once they enter the real world, there are usually trade-offs. (Berry-Jester et al., 2015)

Die Bewertung auf einer Skala von 1 bis 10 vermittelt eine Objektivität, der aber Interpretation bedarf, und eben vor allem statistische Durchschnittswerte zeigt, aber vor allem eine Einzelperson betrifft. Wer behauptet ein Algorithmus würde nur Informationen liefern und sich nicht darum schert, wie diese genutzt werden, handelt verantwortungslos.

- aus Dressel, Julia, and Hany Farid. 2018. “The Accuracy, Fairness, and Limits of Predicting Recidivism.” Science Advances 4 (1), https://doi.org/10.1126/sciadv.aao5580. [↩]

0 Kommentare

1 Pingback