Vor einigen Tagen fand ich einen Artikel bei Technology Review, der ein Forschungsprojekt ankündigt das Kampfszenen in Videoaufnahmen erkennen können soll. Die Idee kam mir bekannt vor und dessen Probleme hab ich in einem Artikel zu einem ähnlichen Projekt in England in diesem Blog schon thematisiert. Der TR Artikel bespricht aber nicht „fightcams“ sondern das Projekt adabts das bereits 2013 abgeschlossen wurde. Einige neue Erkenntnisse gibt es daher schon, „Vorhersagen“ können sie das Verhalten allerdings nicht.

Um zu verstehen wie adabts funktioniert hab‘ ich einen Artikel1 rausgesucht in dem die Forscher*innen die Funktionweise ihres System beschrieben haben, sowie die Abschlusspräsentation des Projekts durchgeschaut.

Die Nachteile des Supervised Learning

Die getesteten Beispiele beziehen sich auf sehr stark strukturierte Orte, in denen der Algorithmus erst „normales“ Verhalten lernt und dann später davon abweichendes Erkennen soll (supervised learning) . Im konkreten Fall wurde eine Eingangshalle gefilmt die Leute entweder einfach durchqueren, dort abgeholt werden oder sich zur Rezeption begeben um von da aus irgendwo hinzugehen. 10 Bewegungsmuster konnte der Algorithmus darin erkennen die 75% der Verhaltensweisen erfassen.

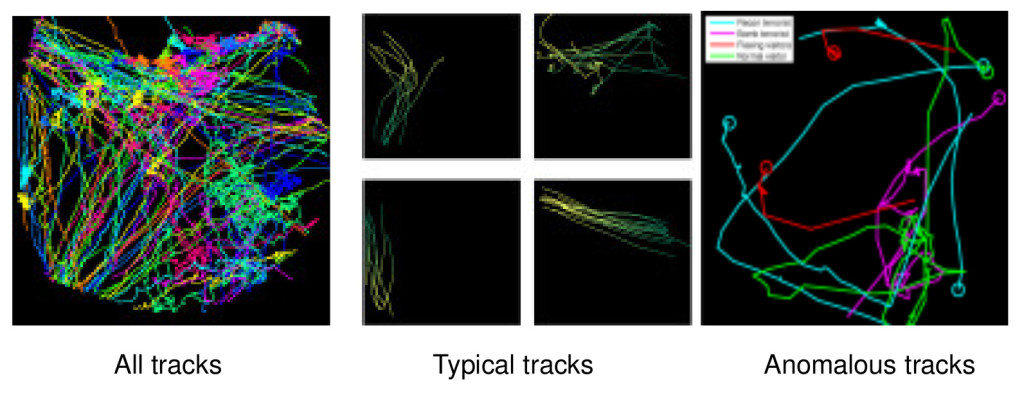

Der Vergleich normaler und anormaler Bewegungsmuster. aus: Gravila, Jansen „Functionalities and Applications“ – Präsentation als PDF.

Der „abnormale“ Fall war dann der Besuch von zwei „Terroristen“ von denen der erste erst den Ort auskundschaftete (also anders rumlief als die übrigen Personen) und ein zweiter dann auf jemanden vom Sicherheitsdienst losgeht. Immerhin scheint das lernen zu funktionieren. Der Algorithmus findet in den Testdaten zwei fliehende Menschen ungewöhnlich und auch das „scouten“ des ersten Terroristen fällt dem Algorithmus auf.

Based on track data of persons in the scene, the system automatically determines typical and anomalous movement patterns, without need for additional user input.

Das Problem: Der Algorithmus findet alles ungewöhnlich, was er nicht schon mal gesehen hat. Am Ende entscheiden also die, die das Video erstellen anhand dessen gelernt wird, was als „normal“ empfunden wird und was nicht. Im Paper beschreiben die Autor*innen, dass jemand der den Raum durchquert, um mit anderen zu sprechen die dort stehen als auffällig markiert wurde, weil das Szenario nicht geübt worden war. Hätte sich dagegen auch im Trainingsvideo jemand derart verhalten wären vermutlich auch die auskundschaftenden „Terroristen“ nicht markiert worden. Besonders praxistauglich scheint mir der Prototyp daher noch nicht. Und: Genau diese Aufgabe können Sicherheitskräfte auch ganz gut übernehmen – wenn sie aufmerksam sind natürlich nur. Sehen wer komisch läuft, sich ungewöhnlich verhält, mit all den Vorurteilen die bei so einer „normal vs. nicht-normal“ Klassifizierung so einhergehen.

Andere Verfahren, die in dem Projekt getestet wurden waren noch

- die Blickrichtungserkennung mit mehreren Kameras, um diejenige Kamera auswählen zu können die eine Person möglichst von vorne filmt.

- In Kombination mit mehreren Mikrophonen soll es auch möglich sein auf einem Kamerabild den genauen Herkunftsort eines Geräusches (z.B. eines Schreis) zu markieren

Die Anwendung

Es überrascht nicht, dass die Autor*innen sich durchaus auch Szenarien jenseits der Verbrechensbekämpfung vorstellen können. So kann die Sound und Bewegungsanalyse auch im Nachhinein benutzt werden um genau zu ermitteln, wer in einer Videosequenz mit welchen Leuten gesprochen hat oder wer in einem bestimmten Areal in den letzten Minuten am häufigsten seine Stimme erhoben hat.

Die Spuren ob das System nun tatsächlich angewendet werden kann verlaufen sich allerdings im Internet. In der Abschlusspräsentation von adabts wird auf das pTrack System von dem wenig sympathischen Rüstungskonzern BAE verwiesen, der angeblich einige der Algorithmen einsetzt, die im Rahmen des Projekts entwickelt wurden. Laut Übersicht werden in pTrack vier Kameras zusammen geschaltet, um beim „Rumlungern in sensitiven Bereichen“ und das betreten „Steriler Zonen“ Alarm zu geben. Auf BAEs Homepage findet sich solch ein Produkt allerdings nicht. Nur die Ankündigung einer Zusammenarbeit mit einer Firma namens IPSOTEK (Randnotiz: Man freue sich über die Zusammenarbeit mit einem Dr Orwell :O) für ein Produkt mit dem Namen Tag and Track.

- Kooij, J.F.P., Englebienne, G., Gavrila, D.M.: A Non-parametric Hierarchical Model to Discover Behavior Dynamics from Tracks. In: Fitzgibbon, A., Lazebnik, S., Perona, P., Sato, Y., and Schmid, C. (eds.) Computer Vision – ECCV 2012. pp. 270–283. Springer Berlin Heidelberg (2012). [↩]

Schreibe einen Kommentar