Der Guardian berichtet, dass die US-Regierung vor Gericht eingestanden hat predictive analytics einzusetzen um zu bestimmen wer auf die No-Fly-Listen kommt. In den USA gibt es seit Jahren gerichtliche Auseinandersetzung um diese Listen, da auch immer wieder Menschen das Besteigen eines Flugzeugs verweigert wird, die sich nichts haben zu schulden kommen lassen. Berühmt geworden ist der Fall eines 8-jährigen, der zwar nicht auf einer No-Fly-Liste stand, aber zumindest auf einer, die vor jedem Flug eine Sonderbehandlung mit sich brachte. Im letzten Jahr sind laut Guardian zudem fünf Muslime auf der Liste gelandet, deren „Vergehen“ (nach eigener Aussage) darin bestand, sich geweigert zu haben mit dem FBI zusammen zu arbeiten.

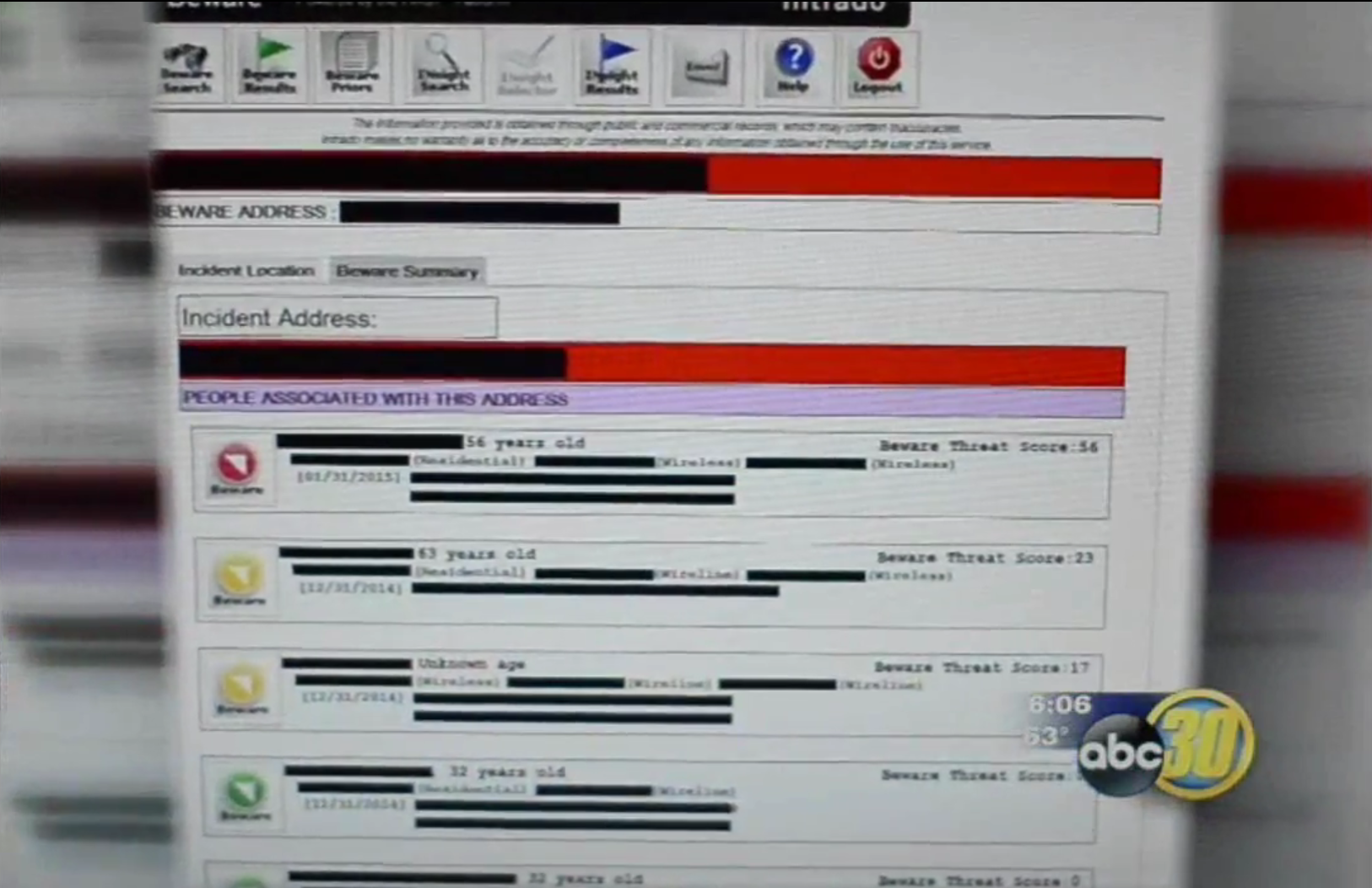

Die genaue Technik ist zwar unbekannt aber es werden immer häufiger Details zur Arbeitsweise bekannt wie und warum Menschen das Fliegen verwehrt wird. Dabei werden offensichtlich häufig nicht (nur) tatsächlich begangenen Straftaten oder verdächtige Aussagen berücksichtigt, sondern eben auch Vermutung darüber angestellt wie gefährlich eine Person sein könnte.

Technisch ist es allerdings wirklich schwierig ein System zu bauen, dass automatisiert Einträge zu dieser Liste hinzufügt. Die Zahl der „falschen“ Einträge (false positives) muss zwangsweise sehr hoch sein, denn wie soll das System auch lernen wer Terrorist_in ist und wer nicht, besonders viele Fälle von denen gelernt werden könnte gibt es ja nicht.